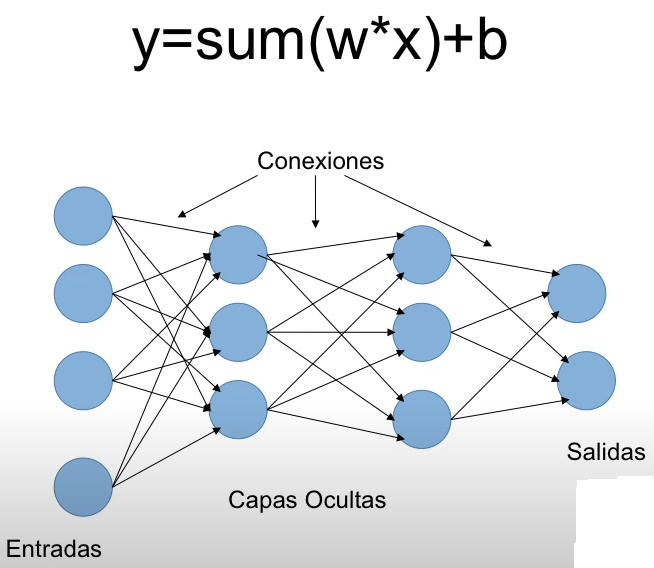

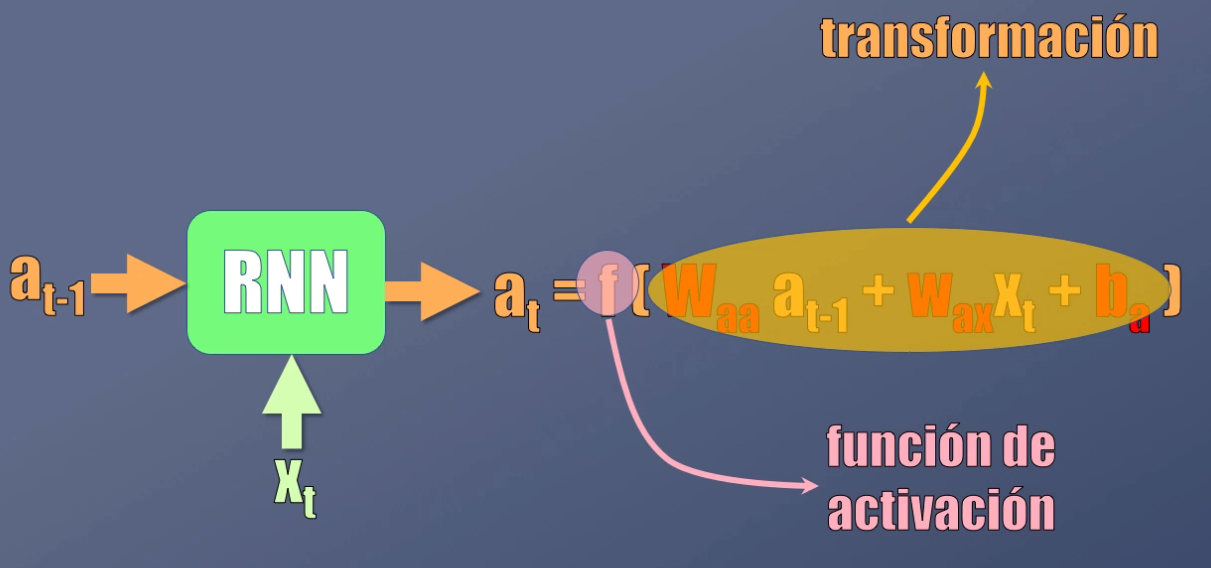

Definición de función de activación: – La función de activación decide si una neurona debe activarse o no calculando la suma ponderada y agregando más sesgo con ella. El propósito de la función de activación es introducir no linealidad en la salida de una neurona. Sabemos que la red neuronal tiene neuronas que funcionan en.. Hasta ahora hemos hablado de la clasificación de las redes neuronales profundas de acuerdo a las siguientes características: Capas. Arquitecturas. Funciones de pérdida. En este texto vamos a mencionar algunas de las funciones de activación más utilizadas en este dominio, esto no representa la totalidad de posibilidades sin embargo deseamos.

¿Qué son las Redes Neuronales? Ejemplos Adictec

Redes Neuronales Características Mind Map

Redes Neuronales 2.4 Funciones de Activación Hackeando Tec YouTube

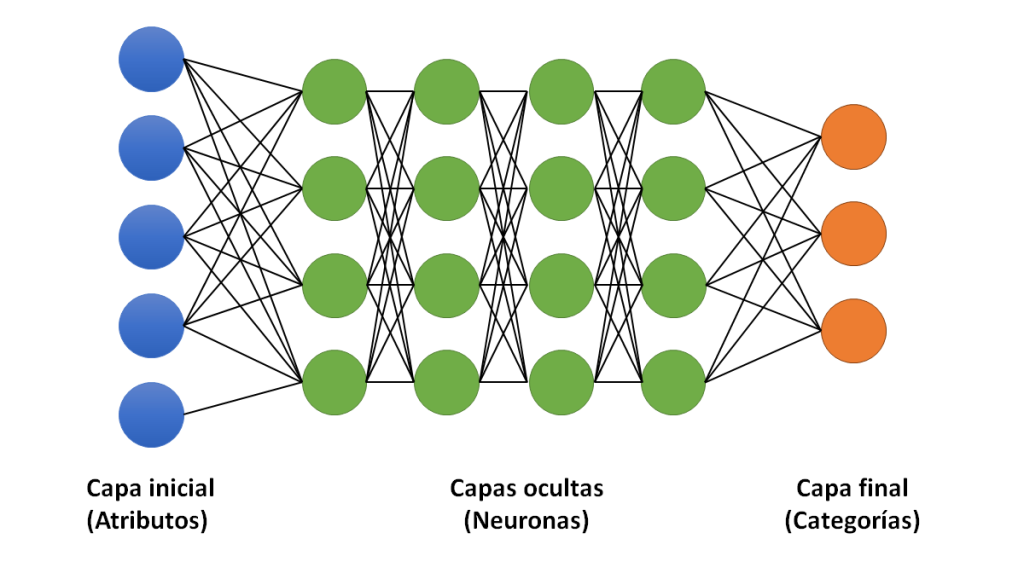

Esquema de la red neuronal para clasificación Interactive Chaos

💡Guía Definitiva de Redes Neuronales Capas Ocultas Back Propagation Pesos y Funcion de

Funciones de activación en una neurona Platzi

Qué son las redes neuronales y sus aplicaciones OpenWebinars

¿Para qué sirven las redes neuronales?

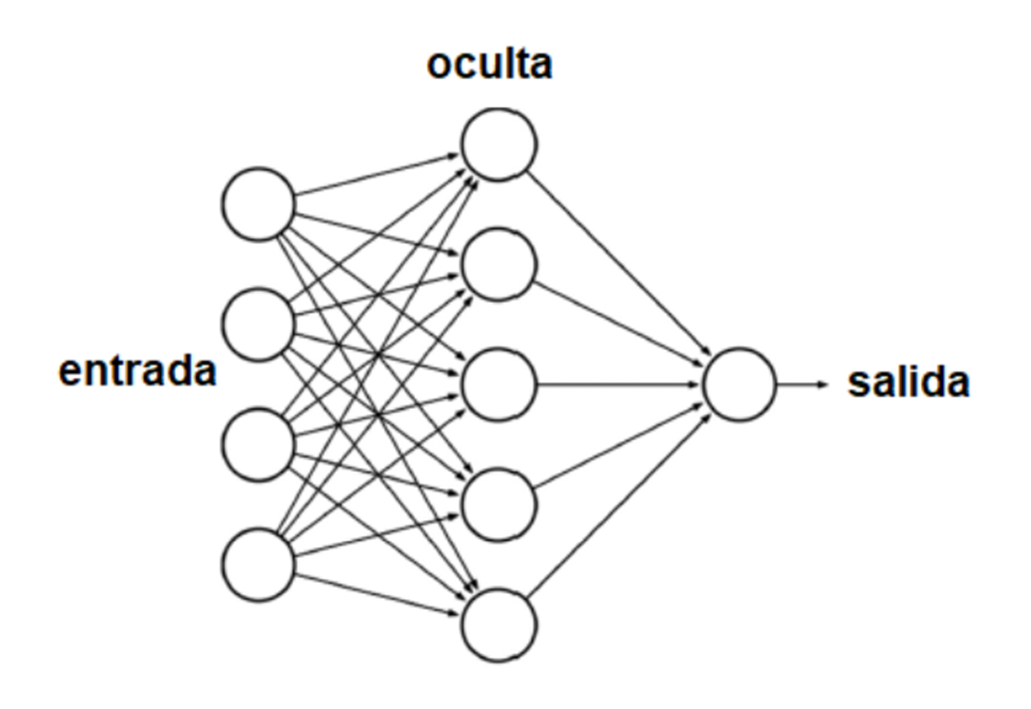

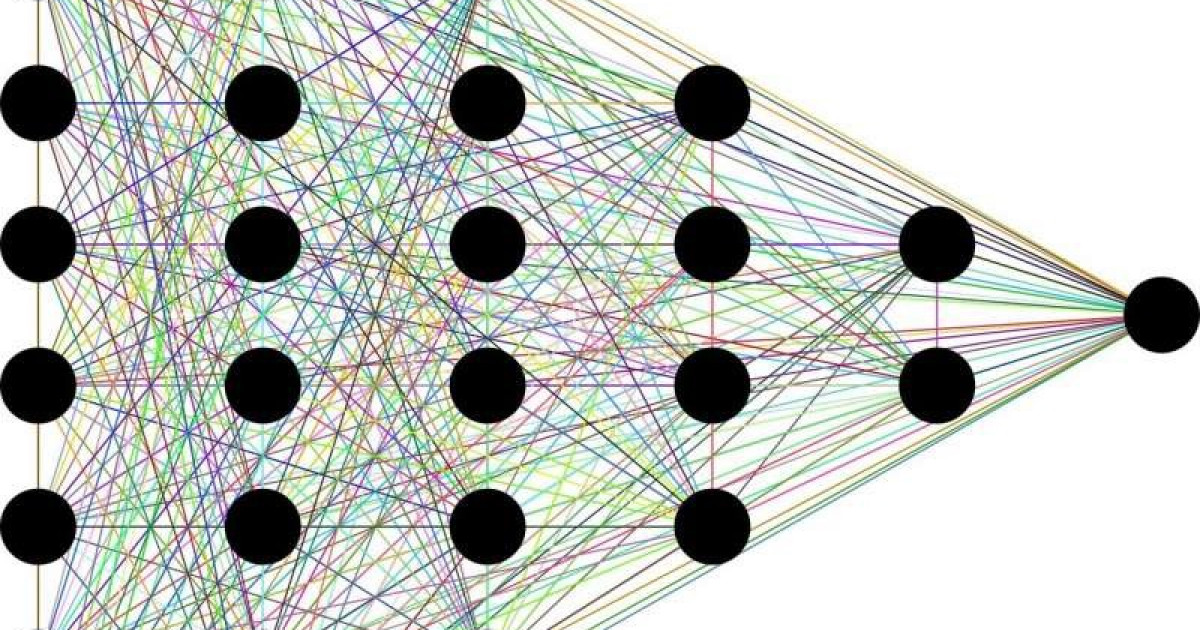

![Breve introducción a redes neuronales [notebook]](https://raw.githubusercontent.com/igomezv/neural_nets_utilities/master/Tutorial_Journal_Club/figures/ANN_.png)

Breve introducción a redes neuronales [notebook]

¿Qué son las redes neuronales y para qué sirven? fácil desde cero Deep Learning YouTube

Explicación sobre la función de las redes neuronales YouTube

Redes Neuronales ¿Qué son y por qué son tan importantes?

Redes neuronales Navideveloper

Redes neuronales profundas qué son y cómo funcionan

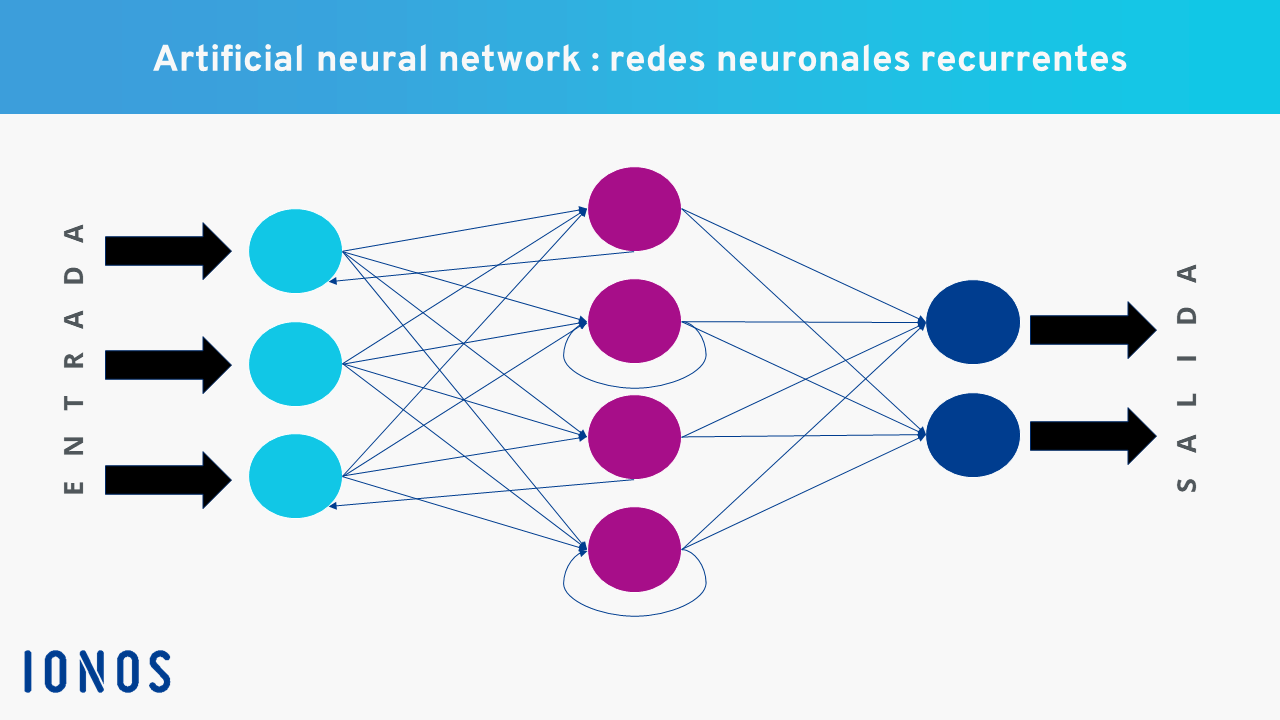

¿Qué es una neural network? IONOS MX

Explicación de las Funciones de activación en Redes Neuronales y práctica con Python. by

Redes Neuronales Recurrentes Explicación Detallada Codificando Bits

Conoce qué son las funciones de activación y cómo puedes crear tu función de activación usando

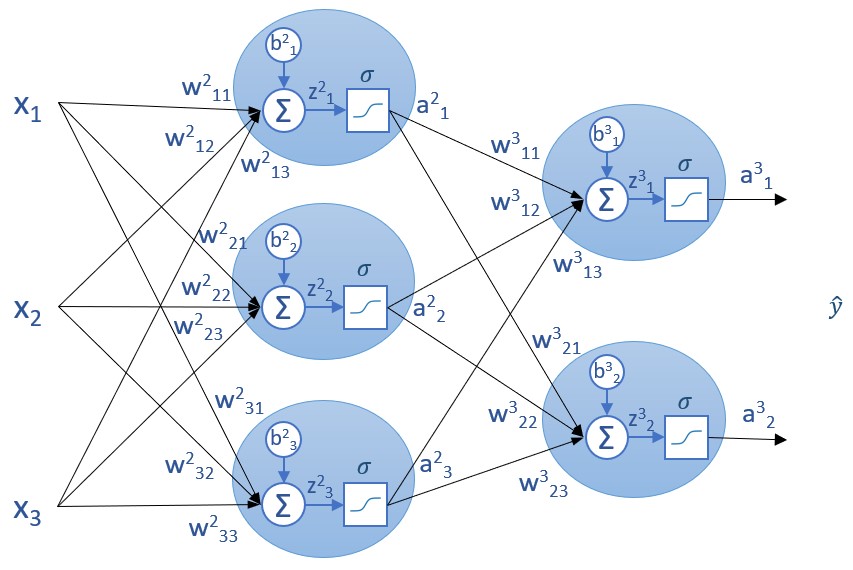

Funciones de activación utilizadas en redes neuronales

¿Qué es una Red Neuronal? Parte 1 La Neurona DotCSV Scenio

Función de activación ReLU (Rectified Linear Unit): Fórmula: f (x) = max (0, x) La función ReLU produce una salida de cero si la suma ponderada es negativa y conserva la suma ponderada si es positiva. Es eficiente en términos computacionales y se utiliza comúnmente en redes neuronales profundas. Ejemplo: Detección de bordes en imágenes.. En los inicios de las redes neuronales se utilizó la función de activación sigmoide debido a la propiedad que tiene de mapear el dominio de los reales al intervalo (0,1), con lo cual se asemeja.